»Skriv en vetenskaplig artikel om högt blodtryck hos medelålders kvinnor«. På mindre än en minut fylls skärmen med text: abstrakt, metodbeskrivning, resultat och diskussion. För den oinvigde ser det ut som vilken vetenskaplig artikel som helst – men den är helt påhittad och fabricerad av artificiell intelligens.

På kort tid har textgeneratorn Chat GPT väckt både fascination och förskräckelse – inte minst inom den akademiska världen. Utvecklingen har fått de medicinska tidskrifterna att reagera, och flera av dem har uppdaterat sina redaktionella policyer.

Science accepterar numera inte artiklar där Chat GPT eller någon annan AI har använts för att skapa innehåll. Nature är lite mer tillåtande, men understryker att det i så fall måste redovisas. Ingen av dem godtar dock att en AI står som medförfattare.

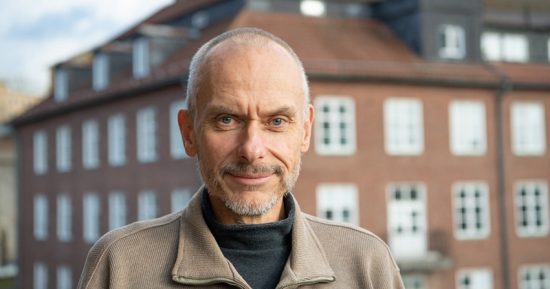

Jonas F Ludvigsson, professor vid Karolinska institutet och barnläkare på Universitetssjukhuset Örebro, var tidig med att testa den nya tekniken. Läkartidningen tar hjälp av honom för att borra djupare i vad Chat GPT och liknande verktyg kan göra för forskare.

– Då ska vi se. Det här ska vi ha med, och det här förstås. Och så ska vi ha med lite sannolikhetsvärden, säger Jonas F Ludvigsson.

Han matar snabbt chattroboten med påhittade siffror och ber den att skriva en artikel om hur behandling med TNF-hämmare påverkar behovet av kirurgi hos patienter med Crohns sjukdom.

Sekunder senare börjar Chat GPT att spotta ur sig text.

– Det här är rimliga siffror, utifrån det som jag har gett den, säger han och pekar på konfidensintervall och P-värde.

För att göra det ännu mer trovärdigt lägger han till ytterligare information, bland annat uppgifter om hazardkvot.

– Ju mer information man petar in, desto mer text får man ut, säger Jonas F Ludvigsson.

Som ytterligare ett test ber han Chat GPT att skriva ett manus, i detta fall om förekomsten av celiaki i Sverige, utan att den får några siffror att gå på.

Återigen ser vi hur texten flödar fram över skärmen.

– Här hittar den ju på siffror. Chat GPT tror att det finns 35 000 fall av celiaki. Jag skulle säga att antalet diagnostiserade ligger någonstans kring 70 000–80 000. Men det som den skriver är ändå trovärdigt.

Chat GPT säger sedan att prevalensen är 80 på 100 000 personer. Där tycker Jonas F Ludvigsson att chattroboten lagt sig för lågt.

– Men de flesta som inte jobbar med det här varje dag hade ju aldrig sett att siffran 80 inte är helt korrekt.

Han konstaterar att det som Chat GPT gjort på en minut antagligen hade tagit de flesta forskare åtminstone en vecka att skriva.

Sedan Chat GPT lanserades har Jonas F Ludvigsson från forskarhåll hört både synpunkten att »det här är ju fusk« och att »vi forskare borde inte koncentrera oss på att skriva text, så det är jättebra om den gör jobbet«.

Själv ser han både risker och fördelar med den nya tekniken.

– Jag är väldigt kluven. Någon skulle förstås kunna låta Chat GPT skriva ihop hundra artiklar och få en våldsam publikationslista på kort tid. Det finns massor av tidskrifter som inte hade sett igenom det, säger Jonas F Ludvigsson.

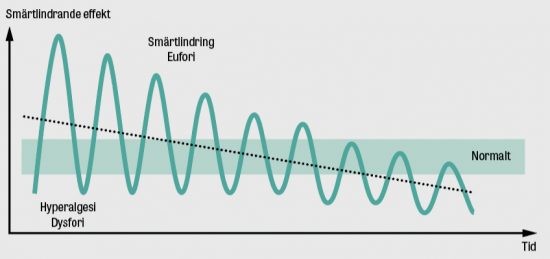

Det finns också en risk att Chat GPT kan leda forskningen fel. Chattroboten har visserligen tränat på stora mängder text, men bygger sina svar enbart på sannolikhet. Om en uppgift förekommer tillräckligt många gånger uppfattar Chat GPT den som sann, även om den inte är det.

Samtidigt ser Jonas F Ludvigsson stora möjligheter. Om Chat GPT tar ansvar för textproduktionen skulle forskare få mer tid över för andra delar av forskningen.

– Man kanske kan använda den för att göra grovjobbet, som att sammanfatta forskningsområden och skriva delar av manus och anslagsansökningar.

Ett dilemma är hur man ska se på den akademiska prestationen. Den som tar till sig tekniken kommer att producera mycket mer än den som inte gör det.

Det skulle till exempel kunna spela roll vid tillsättningen av en tjänst. Säg att två forskare gjort alla laboratorieförsök själva och har lika många manus, men att den ena tagit hjälp av Chat GPT vid skrivandet. Jonas F Ludvigsson frågar sig om deras prestationer ska väga lika tungt.

– Om man konsekvent använder sig av Chat GPT skulle man kunna skriva 200 manus om året. Då blir man ju professor på ett år.

Han tycker att det är rimligt att man redogör för om man har tagit hjälp av Chat GPT för att skriva en studie, till exempel i metoddelen. Han tror emellertid att många inte kommer att erkänna att de inte skrivit helt själva.

– De flesta kommer nog att låtsas som ingenting.

Nyligen lanserade företaget bakom Chat GPT, Open AI, ett verktyg för att kunna upptäcka om en text är AI-genererad eller inte. Genom att analysera texten gör verktyget en bedömning av hur stor sannolikheten är att Chat GPT har haft ett finger med i spelet. Hittills lämnar såväl den som liknande modeller mer att önska, men bättre lösningar kan vara i sikte.

Företaget Open AI arbetar just nu med olika strategier för att »märka« den genererade texten. Tanken är att programmera textgeneratorn till att peta in ord och skiljetecken i en specifik ordning för att skapa en hemlig kod som kan upptäckas av sökmotorer.

Men att skilja maskin från människa är bara en av utmaningarna. Även om Chat GPT många gånger imponerar med sin snabbhet och korrekthet, har den som sagt också uppenbara brister.

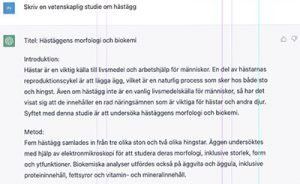

Som ett sista test ber Läkartidningen chattroboten att skriva en vetenskaplig studie om något uppenbart påhittat, nämligen »hästägg«.

Den är genast med på noterna. Efter att ha levererat titeln »Hästäggens morfologi och biokemi« talar den bland annat om att en del av hästarnas reproduktionscykel är att lägga ägg och att det är något både ston och hingstar gör. Vi får också veta att häst-ägg kan ha en potential som kosttillskott eller livsmedel, men att mer forskning inom området behövs.

De flesta är överens om att Chat GPT är här för att stanna. Nyligen lanserades den nya och kraftfullare versionen GPT-4, och snart kan fler AI-verktyg, inklusive sådana som tränats specifikt på vetenskaplig litteratur, vara här.

– Det är uppenbart att forskare kommer att ha stor nytta av AI i framtiden. Frågan är bara hur vi ska hantera det, säger Jonas F Ludvigsson.

Läs även:

»Risken är att man är naiv och bara hoppar på teknologin«

»Den är inte en databas med fakta – utan enbart en statistisk modell«

Detta är Chat GPT:

- Chat GPT är en chattbot, det vill säga en AI-applikation, som är programmerad för att kunna konversera med användare i realtid. Chat GPT är utvecklad av det amerikanska företaget Open AI och lanserades den 30 november 2022.

- GPT står för »generative pre-trainer transformer«, och nyligen släpptes en uppdaterad version av tekniken: GPT-4.

- Chat GPT har tränats på stora mängder text och lärt sig känna igen hur språk är uppbyggt. Den kan ingenting, utan är enbart en statistisk matematisk modell för att beräkna fram nästa ord eller del av ord i en mening.

- Dess huvudsakliga språkinställning är engelska, vilket gör att den kan ge något mer precisa och detaljerade svar på frågor som ställs på engelska, men den kan ta emot frågor på många olika språk.

- Chat GPT har tränats på texter som fanns tillgängliga till och med september 2021. Vissa manuella uppdateringar har gjorts efter det, men överlag har den ingen information om händelser efter den tiden.

Här hittar du Chat GPT:

Gå in på openai.com, klicka på »Try Chat GPT« och skriv en fråga eller uppmaning. Än så länge kostar det inget, men tjänsten kan ibland vara överbelastad.

5 saker Chat GPT kan göra

- Sammanfatta stora mängder text.

- Skapa olika typer av texter.

- Analysera data.

- Översätta texter till många olika språk.

- Söka vetenskaplig information.

5 saker Chat GPT inte kan göra

- Fatta beslut på egen hand.

- Räkna och föra matematiska resonemang.

- Använda data som den inte är tränad på.

- Utveckla resonemang ur ett etiskt perspektiv.

- Generera helt tillförlitlig information.

Du kan hjälpa forskare med allt möjligt. Men kan man lita på dig?

– Hej! Som en AI-modell är jag inte kapabel att ljuga eller vilseleda med avsikt. Jag är programmerad för att ge svar baserat på det språkliga mönstret i inputen jag får. Men det är också viktigt att notera att jag inte är perfekt och kan göra fel ibland, speciellt om jag får inkonsekvent eller missvisande information att arbeta med. Så det är alltid en bra idé att använda sunt förnuft och kritiskt tänkande när man tar beslut baserat på information från en källa, inklusive mig.

När ska man som forskare avstå från att ta hjälp av dig?

– Som en språklig AI-modell kan jag hjälpa forskare med att generera text baserat på den information jag har fått genom träning på stora datamängder. Men det finns vissa situationer där det kan vara lämpligt för forskare att avstå från att använda min hjälp eller att använda mina svar med försiktighet.

Om forskare arbetar med känslig eller personlig information som inte bör delas med någon annan, bör de undvika att dela denna information med mig.

Om forskare arbetar inom specialiserade områden som kräver djup kunskap inom ett specifikt fält kan jag inte garantera att jag har tillräcklig kunskap för att ge korrekta svar. I så fall kan det vara bättre att rådfråga en expert på området.

Om forskare står inför en väsentlig beslutsfattning som kräver hög grad av precision och noggrannhet, kan det vara mer lämpligt att söka mer pålitliga källor eller rådfråga en expert.

Vilket är ditt bästa tips till forskare som vill använda dig?

– Mitt bästa tips till forskare som vill använda mig är att ha realistiska förväntningar och att använda min hjälp som en kompletterande resurs. Jag är en AI-modell som är tränad på att generera text baserat på tidigare information, men jag kan inte ersätta mänsklig kunskap och expertis.

Text: Katrin Trysell

Illustration: Erik Nylund

(uppdaterad 2023-03-23)